1. 자연어 처리(NLP)란 무엇인가?

자연어 처리(Natural Language Processing, NLP)는 컴퓨터가 인간의 언어를 이해하고 생성할 수 있도록 하는 인공지능(AI)의 한 분야로 음성 인식, 기계 번역, 챗봇, 문서 요약 등 다양한 애플리케이션에 활용되고 있습니다.

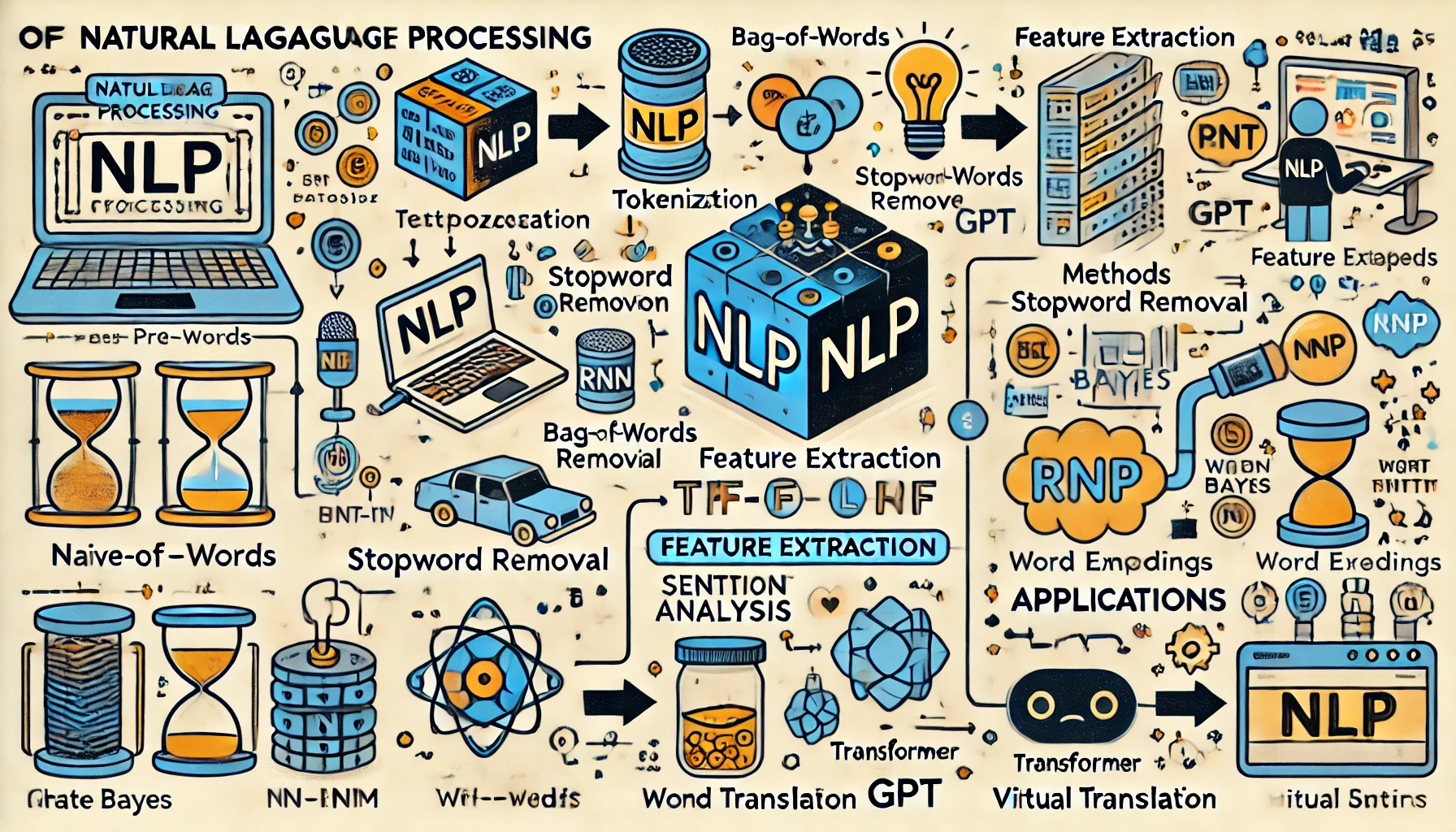

2. NLP의 핵심 구성 요소

1) 텍스트 전처리

자연어 데이터는 비정형 데이터로 구성되므로, 컴퓨터가 처리할 수 있는 형식으로 변환해야 합니다.

• 토큰화(Tokenization): 문장을 단어 또는 구로 나누는 과정.

• 불용어 제거(Stopword Removal): ‘은’, ‘는’, ‘이’와 같은 의미가 적은 단어 제거.

• 어간 추출(Stemming) 및 표제어 추출(Lemmatization): 단어의 기본 형태로 변환.

2) 특징 추출 및 벡터화

언어 데이터는 수치화되어야 모델이 학습할 수 있습니다.

• Bag-of-Words (BoW): 문서를 단어 출현 빈도로 표현.

• TF-IDF(Term Frequency - Inverse Document Frequency): 특정 단어의 중요도를 평가.

• Word Embedding: 단어의 의미를 벡터로 표현하는 기법 (Word2Vec, GloVe, FastText 등).

3. NLP 알고리즘 및 모델 원리

1) 전통적 기법

1. 나이브 베이즈(Naive Bayes)

• 조건부 확률을 이용한 분류 알고리즘.

• 스팸 메일 필터링과 감성 분석에 자주 사용.

2. 의사결정 트리 및 랜덤 포레스트

• 트리 기반 분류 및 회귀 모델.

2) 신경망 기반 기법

1. RNN(Recurrent Neural Networks)

• 순차적 데이터 처리에 특화된 구조로 시계열 데이터 및 텍스트 처리에 강점.

• 문제점: 장기 의존성(Long-term Dependency) 학습 어려움.

2. LSTM(Long Short-Term Memory) 및 GRU(Gated Recurrent Unit)

• RNN의 단점을 보완하여 장기 의존성 문제 해결.

3) 현대적 딥러닝 기법

1. Transformer 모델

• 2017년 Google의 논문 “Attention is All You Need”에서 등장.

https://arxiv.org/abs/1706.03762

• Self-Attention 메커니즘을 활용하여 병렬 처리 성능과 문맥 이해 능력을 대폭 향상.

• 예시: BERT, GPT, T5 등.

2. BERT(Bidirectional Encoder Representations from Transformers)

• 문맥을 양방향으로 고려하여 의미를 이해.

• 자연어 추론, 질의응답, 문장 분류 등 다목적 활용.

3. GPT(Generative Pre-trained Transformer)

• 한 방향으로 문맥을 확장해 자연어 생성에 강점을 보임.

• GPT-3 및 GPT-4는 최신 언어 생성 모델로 창의적인 콘텐츠 생성 가능.

4. NLP 알고리즘 실제 적용 사례

1) 검색 엔진 최적화 및 추천 시스템

• 사용자의 검색 의도를 파악하고 개인화된 추천 제공.

• 예: 구글 검색, 네이버 추천 시스템.

2) 자동 번역 시스템

• 딥러닝 기반 번역 시스템인 Google Translate는 Transformer 모델 활용.

3) 챗봇 및 가상 비서

• GPT 계열 모델과 BERT를 기반으로 한 챗봇과 AI 비서(시리, 구글 어시스턴트) 구현.

4) 감정 분석 및 의견 추출

• 소셜 미디어에서 특정 브랜드나 제품에 대한 사용자 반응 분석.

• 기업의 마케팅 전략 최적화.

5. NLP의 최신 트렌드

1. 초거대 언어 모델의 발전

• GPT-4는 다국어 지원과 멀티모달 기능(텍스트와 이미지를 함께 처리)을 제공하며, 다양한 산업에서 활용되고 있습니다.

• 2024년 출시된 GPT-4o는 기존 GPT-4보다 50% 저렴하고 2배 빠른 성능을 자랑하며, 텍스트 생성과 음성 응답 등 다양한 작업에서 효율성을 높였습니다.

2. 멀티모달 AI의 부상

• 텍스트, 이미지, 음성을 동시에 처리하는 AI 모델의 개발로, 보다 자연스러운 인간-컴퓨터 상호작용이 가능해졌습니다.

3. 대화형 AI의 발전

• 챗봇과 가상 비서의 성능 향상으로 고객 서비스, 교육, 헬스케어 등 다양한 분야에서의 활용이 증가하고 있습니다.

4. 설명 가능한 AI(XAI)에 대한 강조

• AI 모델의 결정 과정을 이해하고 신뢰성을 높이기 위한 연구가 활발히 진행되고 있습니다.

5. 다른 신흥 기술과의 통합

• NLP와 다른 기술(예: 컴퓨터 비전, 로보틱스)의 융합으로 새로운 응용 분야가 개척되고 있습니다.

6. 앞으로의 전망

• 의료 산업: 진단 보고서 분석 및 의학 논문 요약 자동화.

• 법률 분야: 법률 문서 자동 검토 및 계약서 작성 보조.

• 교육 분야: 지능형 튜터 시스템 및 맞춤형 학습 자료 제공.

• 비즈니스 인텔리전스: 시장 분석, 트렌드 예측 자동화.

7. 최신 NLP 도구 및 플랫폼

1) Hugging Face

• 특징: 사전 훈련된 모델(예: BERT, GPT 등)을 쉽게 사용할 수 있는 라이브러리 제공.

• 장점: API 기반 접근 가능, 커뮤니티 지원 풍부.

• 링크: https://huggingface.co

2) OpenAI API

• 특징: GPT-4 및 GPT-4o 등의 고성능 언어 모델을 활용한 API 제공.

• 장점: 멀티모달 처리 및 코드 생성 기능 제공.

• 링크: https://openai.com

3) Google Cloud NLP

• 특징: 구글의 AI 플랫폼으로 다양한 자연어 처리 서비스 제공(감정 분석, 개체 인식 등).

• 장점: 스케일 확장 및 다국어 지원.

• 링크: https://cloud.google.com/natural-language

4) SpaCy

• 특징: 고성능 NLP 라이브러리로 빠른 텍스트 처리 및 모델 학습 지원.

• 장점: 효율적이며 실제 적용에 최적화.

• 링크: https://spacy.io

5) Rasa

• 특징: 대화형 AI 챗봇 및 음성 비서를 구축할 수 있는 오픈소스 프레임워크.

• 장점: 온프레미스(Closed Network) 배포 가능.

• 링크: https://rasa.com

8. 최신 연구 동향 및 발전 방향

1. Adaptive Language Models

• 사용자의 입력에 실시간으로 적응하는 동적 NLP 모델 개발이 활발.

• 예시: OpenAI의 GPT-4o 및 Anthropic의 Claude 3.5.

2. Multimodal AI Integration

• 텍스트, 이미지, 오디오 데이터를 동시에 처리하여 새로운 애플리케이션 가능.

• 예시: GPT-4의 이미지 분석 기능과 CLIP(Contrastive Language–Image Pretraining).

3. Federated Learning in NLP

• 데이터 프라이버시를 보호하면서 분산된 데이터로 모델을 훈련하는 기술.

• 활용 예시: 모바일 키보드의 예측 입력 개선(Gboard).

4. Low-Resource Language Processing

• 자원이 부족한 언어에 대한 NLP 기술 개발 증가.

• 예시: 아프리카 및 아시아 언어에 대한 AI 연구 강화.

5. Explainable AI (XAI)

• AI의 결정 과정을 시각화하고 해석할 수 있도록 하는 기술.

• 활용 예시: 법률 및 의료 분야의 AI 시스템 검증.

9. 실제 구현 예제 코드

1) Hugging Face BERT 활용 예제

from transformers import pipeline

# 감정 분석 파이프라인 설정

classifier = pipeline("sentiment-analysis")

# 입력 데이터

text = ["이 제품 정말 좋아요!", "너무 별로예요."]

# 결과 출력

result = classifier(text)

print(result)

2) GPT-4 API 예제

import openai

openai.api_key = "YOUR_API_KEY"

response = openai.ChatCompletion.create(

model="gpt-4",

messages=[

{"role": "system", "content": "You are an assistant."},

{"role": "user", "content": "자연어 처리란 무엇인가요?"}

]

)

print(response['choices'][0]['message']['content'])

10. 참고 자료 및 출처

1. Attention is All You Need

• 링크: https://arxiv.org/abs/1706.03762

2. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

• 링크: https://arxiv.org/abs/1810.04805

3. Language Models are Few-Shot Learners (GPT-3)

• 링크: https://arxiv.org/abs/2005.14165

4. OpenAI API Documentation

• 링크: https://platform.openai.com/docs

5. Hugging Face Documentation

• 링크: https://huggingface.co/docs

결론

자연어 처리 기술은 여전히 급속히 발전하고 있으며, 초거대 언어 모델, 멀티모달 AI, 설명 가능한 AI(XAI)와 같은 최신 연구들이 새로운 가능성을 열어가고 있습니다.

궁금한 점이나 추가 질문이 있으시면 언제든지 댓글이나 문의 주세요!

'AI Algorithms (AI 기술과 알고리즘)' 카테고리의 다른 글

| 📘 멀티모달 Reasoning을 위한 시맨틱 Alignment 기법의 진화: VideoCoT, MM-ReAct, 그리고 MoME (0) | 2025.05.20 |

|---|---|

| AI 전략의 미래: 중앙 집중형 모델에서 분산형 에이전트 네트워크로 (0) | 2025.04.28 |

| LLM 애플리케이션을 위한 새로운 프레임워크, DSPy 완전 정복 (0) | 2025.04.22 |

| 개발 전에 디자인부터? 디자인 주도 개발의 장단점 총정리 (0) | 2025.04.10 |

| Haystack 기반 RAG 시스템 구축 시작하기 (5) | 2025.01.09 |